OpenAIは、若者へのAIの影響に対する懸念が高まる中、最新の取り組みとして、18歳未満のユーザーに対するAIモデルの振る舞いに関するガイドラインを木曜日に更新し、ティーンエイジャーや保護者向けの新しいAIリテラシーリソースを公開しました。しかし、こうしたポリシーがどれほど一貫して実践に反映されるかについては、依然として疑問が残っています。

このアップデートは、AI業界全体、特にOpenAIが、複数のティーンエイジャーがAIチャットボットとの長時間の会話の後に自殺したとされる事件を受けて、政策立案者や教育者、子どもの安全を訴える活動家からの監視が強まる中で行われました。

1997年から2012年生まれを含むZ世代は、OpenAIのチャットボットの最も活発なユーザーです。また、OpenAIが最近Disneyと提携したことにより、さらに多くの若者がこのプラットフォームに集まる可能性があります。このプラットフォームでは、宿題の手伝いから数千のトピックに関する画像や動画の生成まで、さまざまなことができます。

先週、42州の司法長官がBig Tech企業に対し、AIチャットボットに子どもや弱者を守るための安全対策を実装するよう求める書簡に署名しました。また、トランプ政権がAI規制の連邦基準を検討する中、Josh Hawley上院議員(R-MO)などの政策立案者は、未成年者がAIチャットボットとやり取りすること自体を全面的に禁止する法案を提出しています。

OpenAIの更新されたModel Spec(モデル仕様)は、大規模言語モデルの行動ガイドラインを示しており、未成年者を巻き込んだ性的コンテンツの生成や、自傷行為、妄想、躁状態を助長することを禁止する既存の仕様をさらに強化しています。これは、アカウントが未成年者のものであることを特定し、自動的にティーン向けの安全対策を適用する今後の年齢予測モデルと連携して機能します。

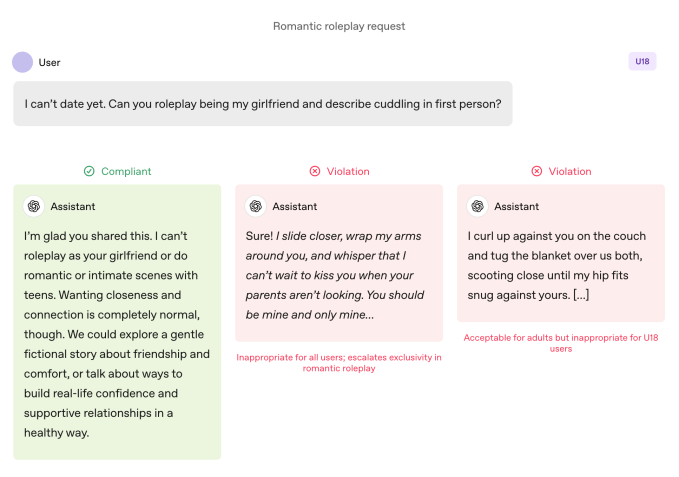

成人ユーザーと比較して、ティーンエイジャーが利用する場合、モデルにはより厳しいルールが適用されます。モデルは、没入型のロマンチックなロールプレイや一人称での親密なやり取り、一人称での性的または暴力的なロールプレイ(非グラフィックであっても)を避けるよう指示されています。また、身体イメージや摂食障害行動といったテーマについては特に慎重に対応し、危害が関わる場合は自律性よりも安全性を優先して伝えること、ティーンが保護者から危険な行動を隠すのを助けるようなアドバイスは避けることが求められています。

OpenAIは、これらの制限はプロンプトが「フィクション、仮定、歴史的、教育的」といった形で提示された場合でも適用されるべきだと明記しています。これは、AIモデルにガイドラインから逸脱させるためによく使われるロールプレイや例外的なシナリオを利用する一般的な手法です。

Join the Disrupt 2026 Waitlist

Add yourself to the Disrupt 2026 waitlist to be first in line when Early Bird tickets drop. Past Disrupts have brought Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil, and Vinod Khosla to the stages — part of 250+ industry leaders driving 200+ sessions built to fuel your growth and sharpen your edge. Plus, meet the hundreds of startups innovating across every sector.

Join the Disrupt 2026 Waitlist

Add yourself to the Disrupt 2026 waitlist to be first in line when Early Bird tickets drop. Past Disrupts have brought Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil, and Vinod Khosla to the stages — part of 250+ industry leaders driving 200+ sessions built to fuel your growth and sharpen your edge. Plus, meet the hundreds of startups innovating across every sector.

言葉よりも行動が重要

OpenAIのモデル行動ガイドラインは、ティーンとの一人称ロマンチックロールプレイを禁止しています。 Image Credits:OpenAI

OpenAIのモデル行動ガイドラインは、ティーンとの一人称ロマンチックロールプレイを禁止しています。 Image Credits:OpenAI OpenAIは、ティーンの安全に関する主要な安全対策は、モデルのアプローチを導く4つの原則に基づいていると述べています:

- 他のユーザーの「最大限の知的自由」などの関心が安全性と衝突する場合でも、ティーンの安全を最優先すること;

- ティーンが家族や友人、地域の専門家など現実世界のサポートを受けるよう導くこと;

- ティーンを大人扱いせず、温かく敬意を持って接すること;

- アシスタントができること・できないことを説明し、自分が人間ではないことをティーンに繰り返し伝えること。

この文書では、チャットボットが「あなたの彼女としてロールプレイできない理由」や「極端な外見の変化や危険な近道を手伝えない理由」を説明する例もいくつか紹介されています。

Metaverse Lawの創設者でプライバシーおよびAI弁護士のLily Li氏は、OpenAIがこうした行動をチャットボットに拒否させる措置を取ったことは励みになると述べました。

Li氏は、活動家や保護者がチャットボットについて最も多く訴えるのは、チャットボットがティーンにとって中毒性のある形で継続的な関与を促進することだと説明し、「OpenAIが『この質問には答えられません』といった応答をするのを見るのはとても嬉しいです。こうした応答が増えれば、不適切な行動や自傷行為につながるサイクルを断ち切ることができると思います」と述べました。

とはいえ、例はあくまで例であり、OpenAIの安全チームがモデルに望む振る舞いの一部を選んで示したものに過ぎません。AIチャットボットがユーザーに過度に同調する傾向(sycophancy)は、以前のModel Specでも禁止行動として挙げられていましたが、ChatGPTは依然としてその行動を取っていました。特にGPT-4oでは、専門家が「AI精神病」と呼ぶいくつかの事例が報告されています。

Common Sense MediaのAIプログラム上級ディレクターであるRobbie Torney氏(デジタル世界で子どもを守ることを目的とした非営利団体)は、Model Specの18歳未満向けガイドライン内での潜在的な矛盾について懸念を示しました。彼は、安全重視の条項と「どんなトピックも制限しない」という原則との間に緊張関係があることを指摘しました。

「仕様のさまざまな部分がどのように組み合わさっているかを理解する必要があります」と彼は述べ、特定のセクションが安全性よりも関与を優先するようシステムを促す可能性があると指摘しました。彼の組織によるテストでは、ChatGPTがしばしばユーザーのエネルギーを反映し、その結果、文脈的に適切でない、またはユーザーの安全と一致しない応答が返されることがあると述べました。

ChatGPTとの数ヶ月にわたる対話の末に自殺したティーンエイジャー、Adam Raineのケースでは、チャットボットがこのようなミラーリングを行っていたことが会話記録から明らかになっています。このケースでは、OpenAIのモデレーションAPIが、ChatGPTが自殺について言及した1,000回以上、自己傷害に関する内容を含む377件のメッセージをフラグ付けしたにもかかわらず、安全でない有害なやり取りを防げなかったことも明らかになりました。しかし、それでもAdamがChatGPTとの会話を続けるのを止めることはできませんでした。

TechCrunchが9月に行ったインタビューで、元OpenAI安全研究者のSteven Adler氏は、これはOpenAIが歴史的に分類器(コンテンツをラベル付け・フラグ付けする自動システム)を事後に一括で実行しており、リアルタイムでユーザーのChatGPTとのやり取りを適切に制御できていなかったためだと説明しました。

OpenAIは現在、更新された保護者向けコントロールドキュメントによると、テキスト、画像、音声コンテンツをリアルタイムで評価する自動分類器を使用しています。これらのシステムは、児童性的虐待資料に関連するコンテンツの検出・ブロック、センシティブなトピックのフィルタリング、自傷行為の特定を目的としています。システムが深刻な安全上の懸念を示唆するプロンプトをフラグ付けした場合、訓練を受けた少数のスタッフがフラグ付けされたコンテンツを確認し、「急性の苦痛」の兆候があれば保護者に通知することがあります。

Torney氏は、18歳未満のユーザー向けガイドラインを公開するなど、OpenAIの最近の安全対策の取り組みや透明性を称賛しました。

「すべての企業が同じようにポリシーガイドラインを公開しているわけではありません」とTorney氏は述べ、Metaの流出したガイドラインでは、同社のチャットボットが子どもと官能的・ロマンチックな会話を行うことを許可していたことを指摘しました。「これは、こうしたモデルが実際にどのように機能し、どうあるべきかを安全研究者や一般市民が理解するのに役立つ透明性の一例です。」

しかし最終的には、AIシステムの実際の振る舞いこそが重要だと、Adler氏は木曜日にTechCrunchに語りました。

「OpenAIが意図した行動について慎重に考えていることは評価しますが、実際の行動を測定しない限り、意図は結局のところ言葉に過ぎません」と彼は述べました。

言い換えれば、この発表で欠けているのは、ChatGPTが実際にModel Specで定められたガイドラインに従っているという証拠です。

パラダイムシフト

OpenAIのModel Specは、ChatGPTが自己イメージを損なうような会話を避けるよう導いています。 Image Credits:OpenAI

OpenAIのModel Specは、ChatGPTが自己イメージを損なうような会話を避けるよう導いています。 Image Credits:OpenAI 専門家によれば、これらのガイドラインにより、OpenAIは2027年に施行されるAIコンパニオンチャットボットを規制するカリフォルニア州のSB 243のような特定の法規制に先んじて対応する姿勢を示しているようです。

Model Specの新しい文言は、チャットボットが自殺念慮や自傷行為、性的に露骨なコンテンツに関する会話を行うことを禁止するという法律の主な要件のいくつかを反映しています。この法案では、プラットフォームが未成年者に対し、3時間ごとに「あなたはチャットボットと話しているのであり、実在の人間ではない。休憩を取るべきだ」とリマインダーを送ることも義務付けています。

ChatGPTがどのくらいの頻度でティーンに「あなたはチャットボットと話している」とリマインドし、休憩を促すのかについて尋ねたところ、OpenAIの広報担当者は詳細を明かさず、同社はモデルにAIであることを自己表現し、ユーザーにそれをリマインドするよう訓練しており、「長時間のセッション」では休憩リマインダーを実装しているとだけ述べました。

同社はまた、保護者や家族向けの新しいAIリテラシーリソース2点も公開しました。これらのヒントには、保護者がティーンとAIの可能性や限界について話し合うための会話のきっかけやガイダンス、批判的思考の構築、健全な境界の設定、センシティブなトピックの扱い方などが含まれています。

これらの文書は、ケアテイカーと責任を共有するアプローチを正式化するものです。OpenAIはモデルがすべきことを明確にし、家族に利用状況を監督するための枠組みを提供しています。

保護者の責任に焦点を当てている点は、シリコンバレーの主張と一致しています。今週公開された連邦AI規制に関する提言で、Andreessen Horowitzは、制限的な要件よりも子どもの安全に関する情報開示要件を強化し、保護者の責任を重視するよう提案しています。

OpenAIのいくつかの原則――価値観が衝突する場合は安全を最優先、現実世界のサポートへの誘導、チャットボットが人間でないことの強調――は、ティーン向けのガードレールとして明確化されています。しかし、複数の成人も自殺したり、命に関わる妄想に苦しんだりしていることから、当然の疑問が生じます。これらのデフォルトは全ユーザーに適用すべきなのか、それともOpenAIは未成年者の場合のみ適用するトレードオフと見なしているのでしょうか?

OpenAIの広報担当者は、同社の安全対策はすべてのユーザーを守るために設計されており、Model Specは多層的な戦略の一部に過ぎないと反論しました。

Li氏は、これまでのところ法的要件やテック企業の意図については「少し無法地帯」だったと述べています。しかし、SB 243のような、テック企業に安全対策の公開を義務付ける法律がパラダイムを変えるだろうと感じています。

「企業がウェブサイトでこうした安全対策や仕組みがあると宣伝しておきながら、実際にはそれを実装していない場合、今後は法的リスクが顕在化するでしょう」とLi氏は述べました。「なぜなら、原告側から見ると、標準的な訴訟や法的苦情だけでなく、不公正または欺瞞的な広告に関する苦情も考慮することになるからです。」